在容器实例中使用内置的 Ollama DeepSeek-R1

Ollama 是一个支持在本地快速部署和运行大型语言模型的开源工具。智算平台上现已内置 Ollama 镜像和 DeepSeek 模型文件,用户可通过创建容器实例,快速使用自定义专属模型。

前提条件

-

已经获取控制台账户和密码。

-

已完成实名认证且账户余额大于 0 元。

资源要求

不同 DeepSeek 模型的大小及资源需求如下:

| 模型 | 模型大小 | 最低资源需求 | 建议资源需求 |

|---|---|---|---|

deepseek-r1:1.5b |

1.1G |

西北 3 区 4090 24G * 1 |

西北 3 区 4090 24G * 1 |

deepseek-r1:7b |

4.4G |

西北 3 区 4090 24G * 1 |

西北 3 区 4090 24G * 1 |

deepseek-r1:8b |

4.6G |

西北 3 区 4090 24G * 1 |

西北 3 区 4090 24G * 1 |

deepseek-r1:14b |

8.4G |

西北 3 区 4090 24G * 1 |

西北 3 区 4090 24G * 2 |

deepseek-r1:32b |

19G |

西北 3 区 4090 24G * 1 |

西北 3 区 4090 24G * 2 |

deepseek-r1:70b |

40G |

西北 3 区 4090 24G * 2 |

西北 3 区 4090 24G * 4 |

| 注意 |

|---|

容器实例默认系统盘可用空间为 50GB,注意模型大小与磁盘空间。 |

操作步骤

创建容器实例

-

在顶部导航栏,选择产品与服务 > AI 算力云服务 > AI 算力云服务。

-

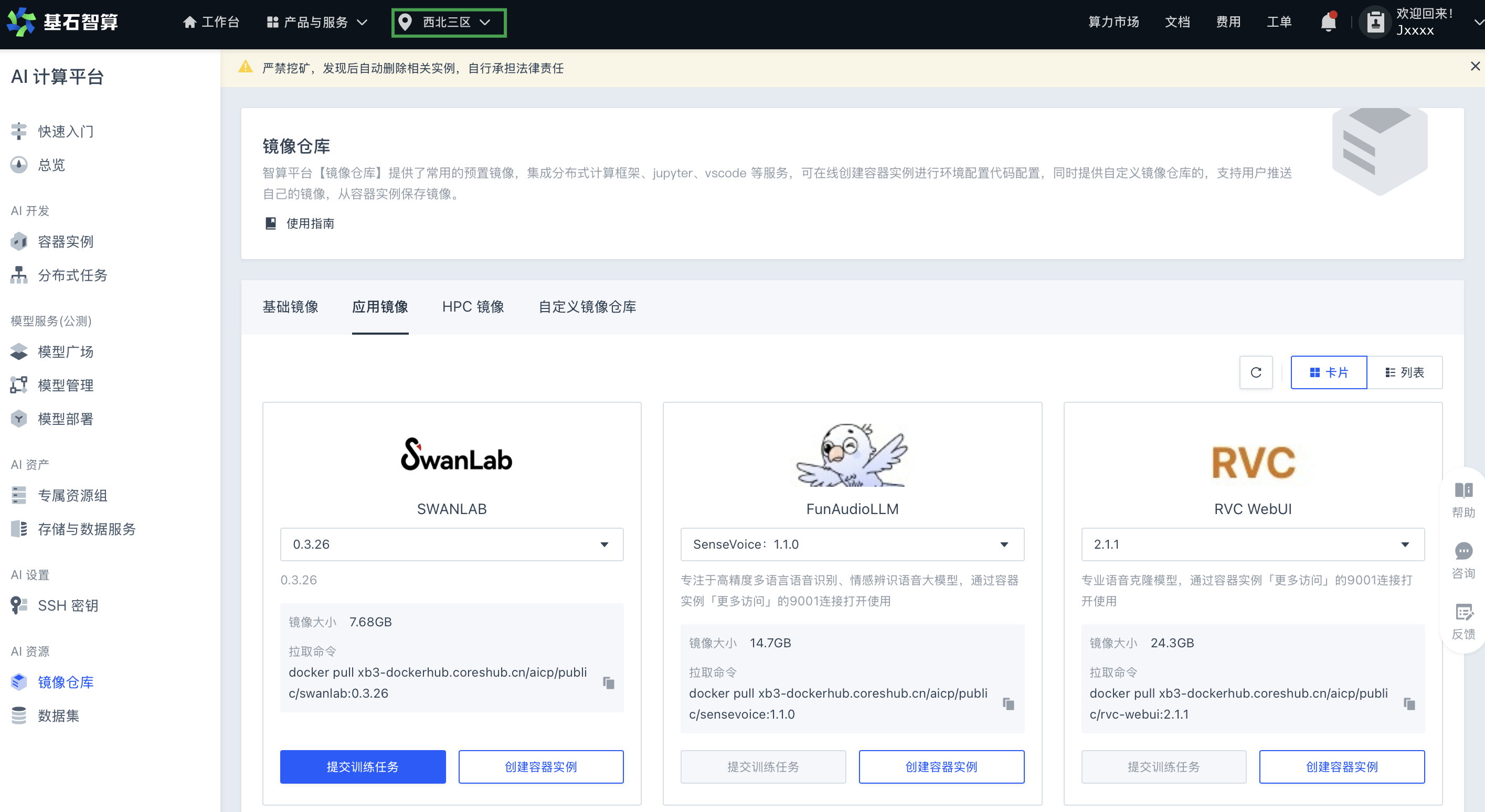

进入 AI 计算平台,在顶部导航栏,选择西北三区。

-

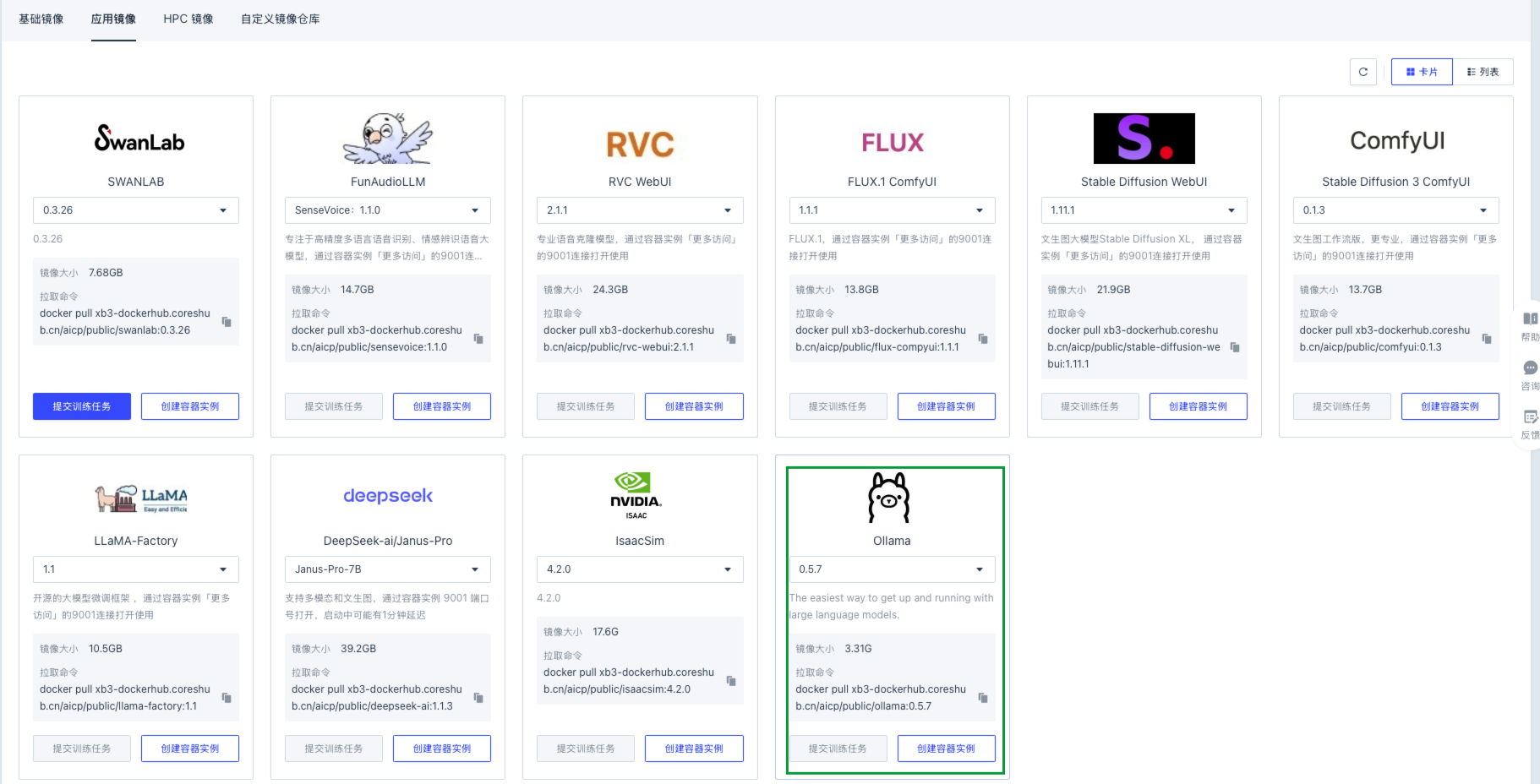

在左侧导航栏中,点击镜像仓库,选择应用镜像页签。

-

在 Ollama 镜像卡片页内,点击创建容器实例。

-

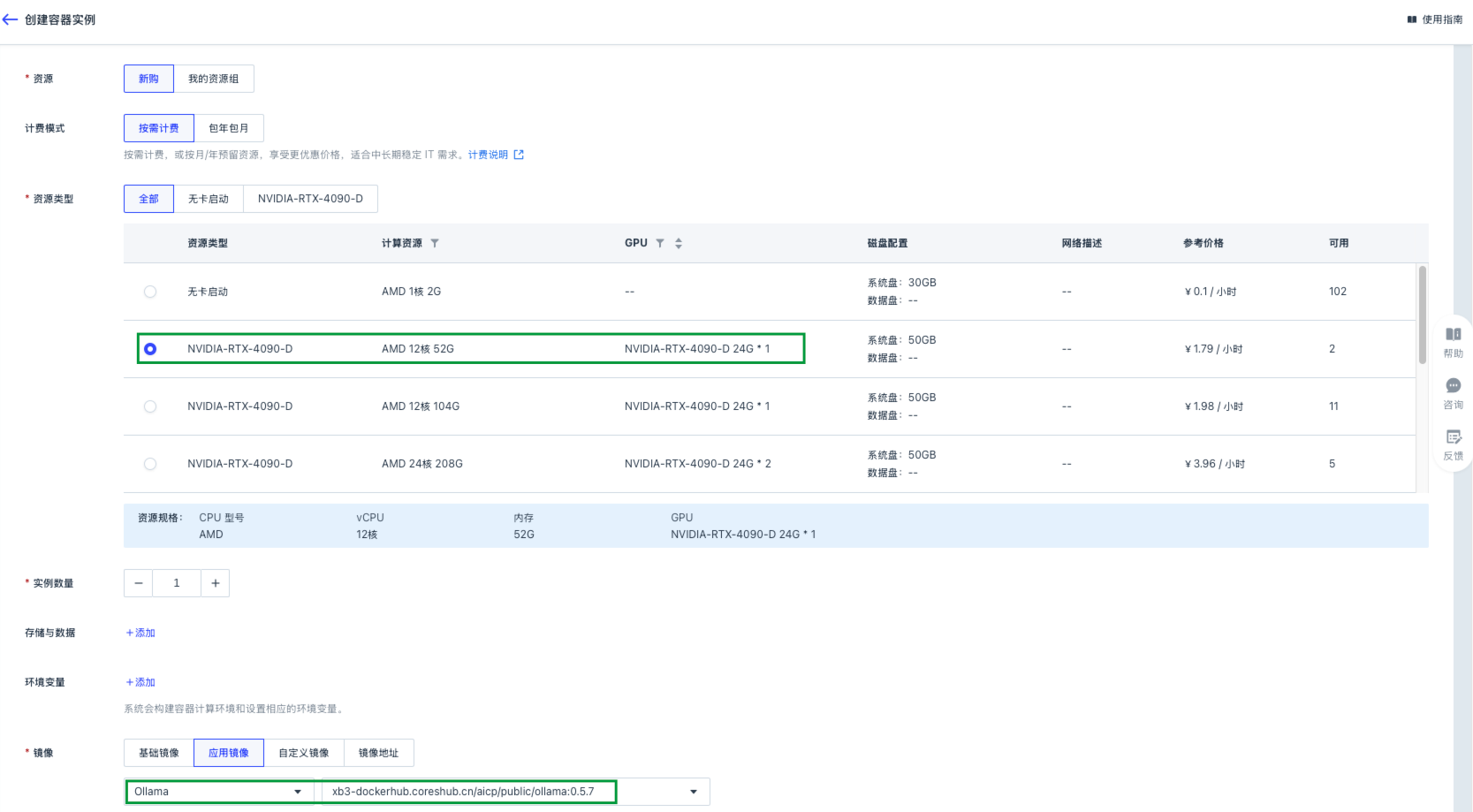

进入创建容器实例页面,根据如下要求配置各项参数,点击创建。

-

资源类型:推荐选择 NVIDIA-GeForce-RTX-4090 24G*1 GPU 资源。 -

镜像:已选择上一步选定的应用镜像。 -

其他参数,根据实际情况进行设定即可。

-

启动 Ollama 服务

-

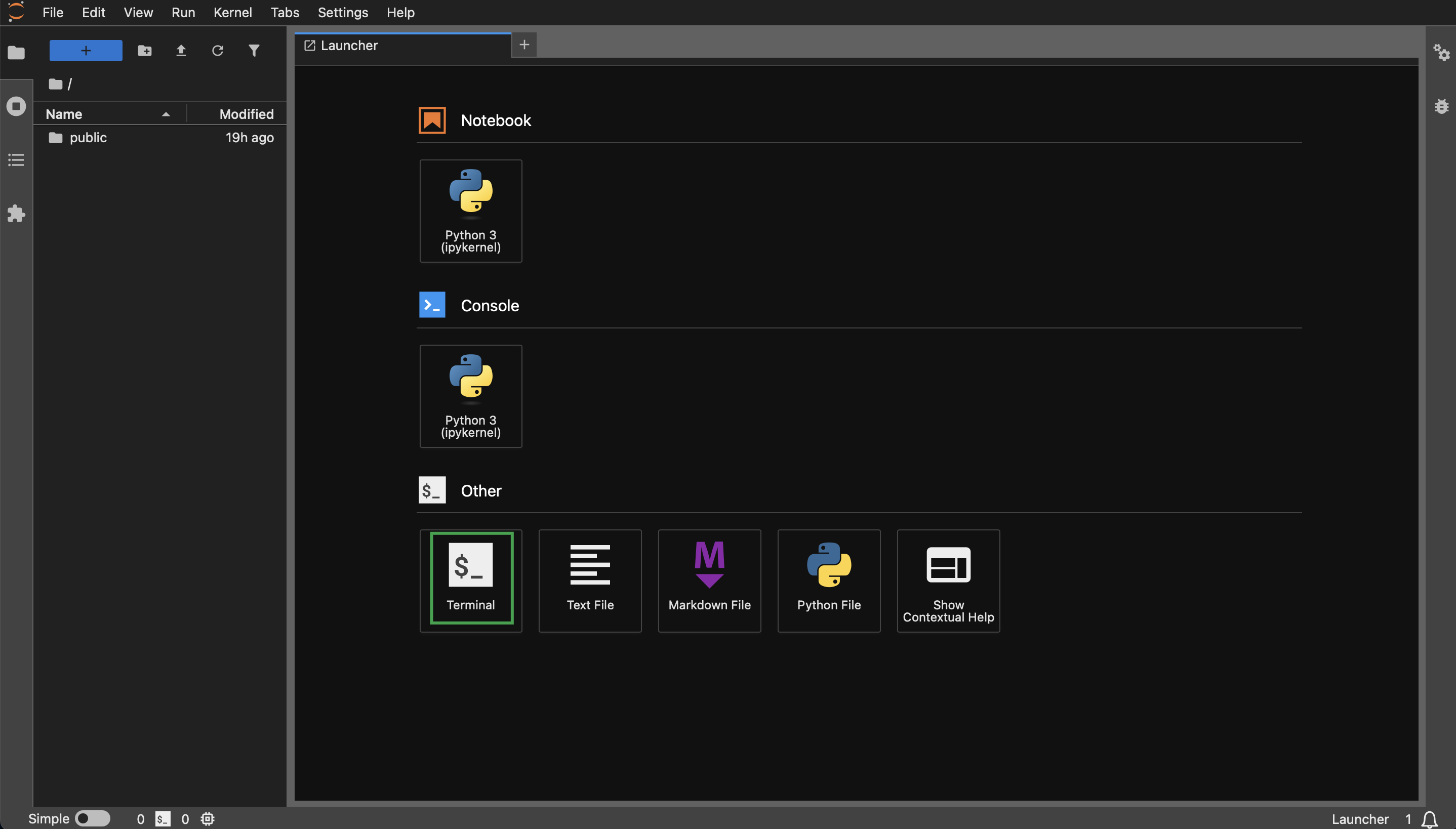

延续上述操作,等待容器实例创建完成,且状态为

运行中,在实例列表内点击该容器实例快捷开发列中的 jupyter,打开 JupyterLab 页面。说明 JupyterLab 的使用方法可参考前文内容。

-

在 JupyterLab 页面,选择 Other > Terminal,新建终端窗口。

-

执行如下命令,设置 Ollama 的端口,本文后续所有 Ollama 的命令,均需设置此环境变量,Ollama 才可以正常使用。

export OLLAMA_HOST=0.0.0.0:9001说明 Ollama 默认前台运行,若用户需后台运行,可再执行

ollama serve &命令。

配置和查看 Ollama 模型

-

延续上述操作,依次执行如下命令,将 Ollama 的 DeepSeek-R1 模型拷贝至容器实例本地。

cp -nr /root/public/Ollama/deepseek-r1/1.5b/* /root/.ollama/ cp -nr /root/public/Ollama/deepseek-r1/7b/* /root/.ollama/说明 本实践中以拷贝 1.5b 和 7b 模型为例,其他模型拷贝方法类似,用户修改相应目录名称即可。

-

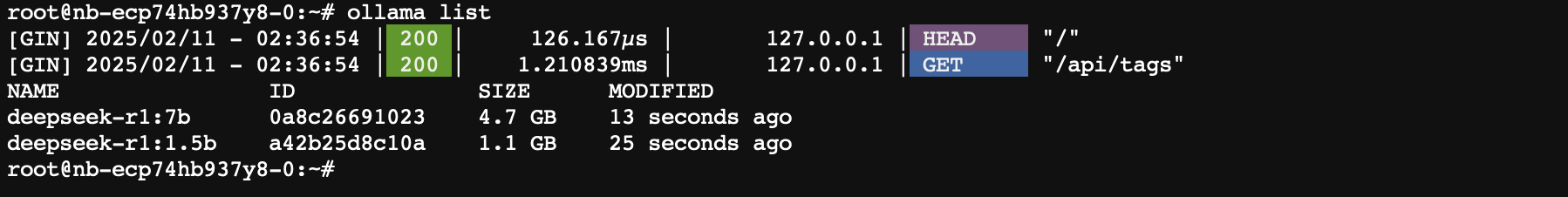

执行如下命令,查看已拷贝完成的模型列表。

ollama list回显示例:

-

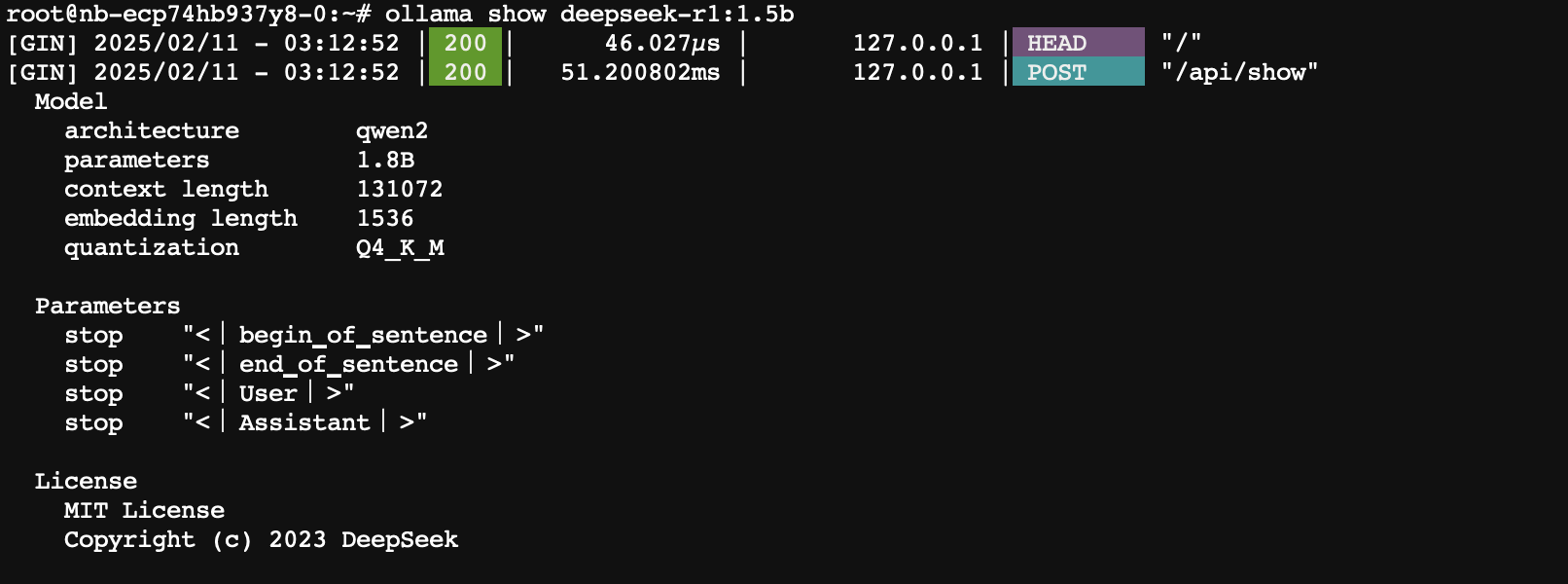

执行如下命令,查看模型的具体参数信息。

ollama show <deepssek_mode_name>其中,

<deepssek_mode_name>为上一步获取的模型名称,如deepseek-r1:1.5b或deepseek-r1:7b,需根据根据实际情况进行修改。命令示例:

ollama show deepseek-r1:1.5b回显示例:

运行 Ollama 模型

-

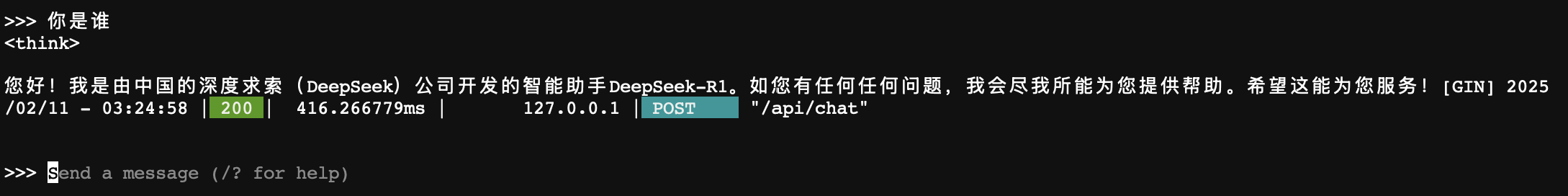

延续上述操作,执行如下命令,运行 Ollama 模型,以运行

deepseek-r1:1.5b模型为例。ollama run deepseek-r1:1.5b -

根据页面提示,输入相关问题。用户即可使用 Ollama 中的 DeepSeek 模型进行对话。

第三方客户端 API 调用配置

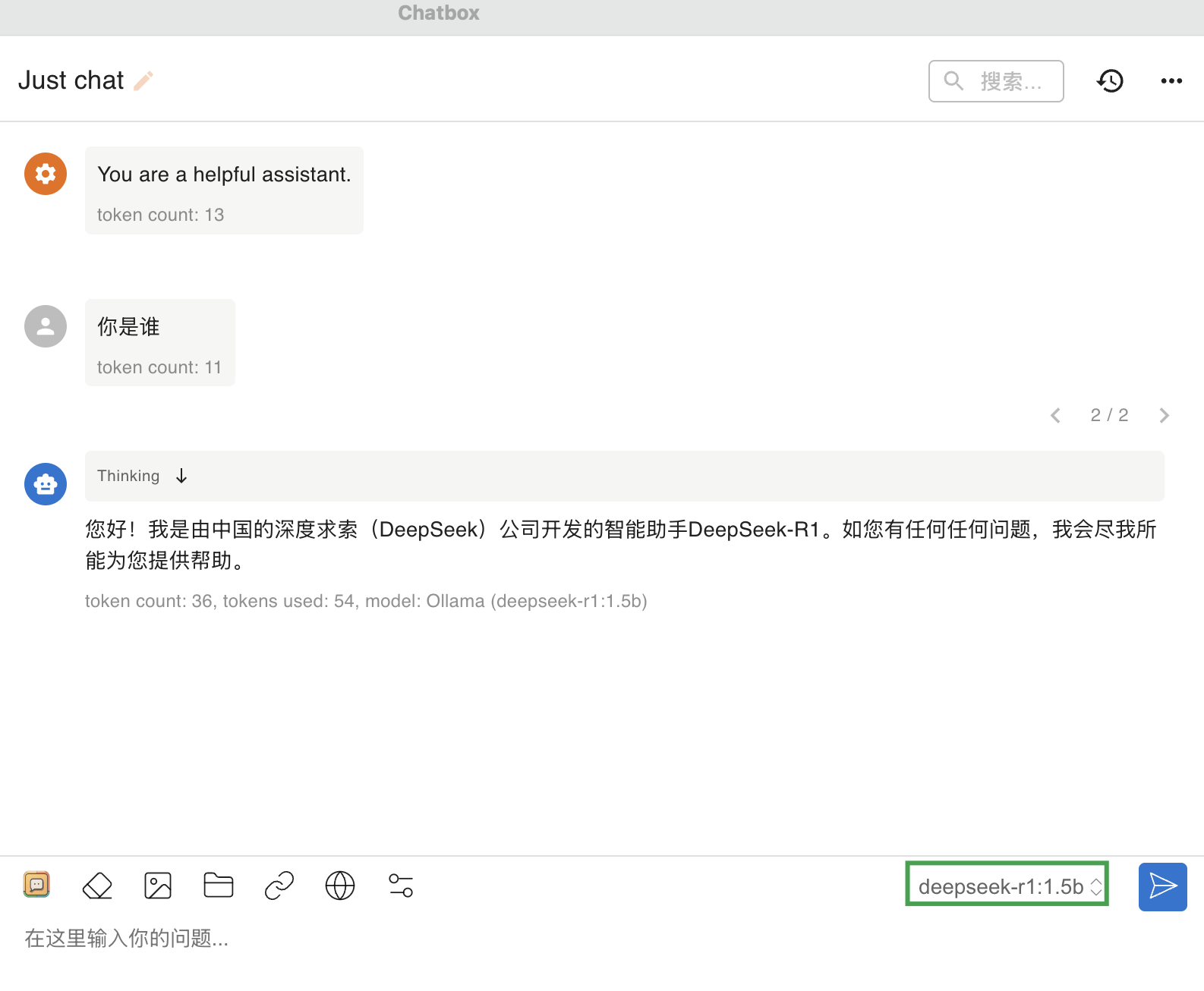

本实践以 Chatbox 客户端为例,其他第三方客户端,用户可自行参考其相应官方教程。

-

返回容器实例列表页面,点击更多访问。

-

在弹出的更多访问信息窗口中,记录 9001 端口对应的地址。

说明 启动 Ollama 服务操作中已指定 9001 端口。

-

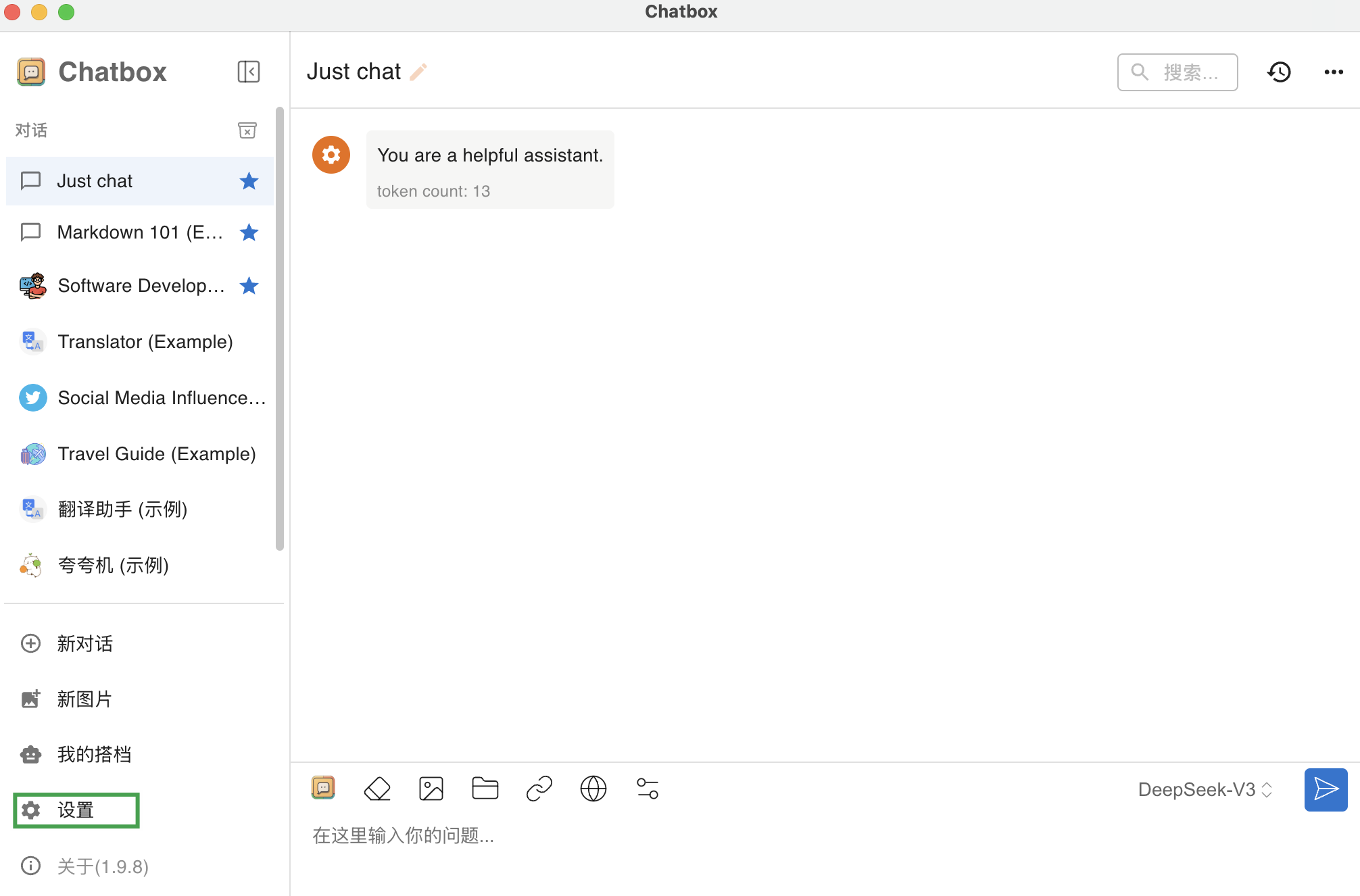

启动并登录 Chatbox 客户端,点击界面左下角的设置。

-

在弹出的设置窗口中,配置各项参数,点击保存即可。

-

模型提供方:此处选择OLLAMA API。 -

API 域名:容器实例 9001 端口对应的地址,需根据实际情况进行修改。 -

模型:系统将自动获取 API 域名下可用的模型,用户自行选择即可。 -

其他参数,用户可根据实际情况进行修改或保持默认。

-

-

在 Chatbox 的 Just chat 界面,即可使用 Ollama 内置的 DeepSeek 模型进行对话。

其他模型的使用

若使用其他智算平台上未内置的模型时,可以采用如下方法:

-

当执行

ollama run <model_name>指令时,若模型不存在则会先进行下载,如果存在则使用已经下载好的模型。 -

如果用户有其他模型使用的需求,我们建议您通过工单联系我们,由我们将模型进行内置,以便提升模型的使用效率。

-

有些模型需要的存储空间可能会超过系统盘空间的限制,此时可以将

/root/.ollama目录软连接到一个较大的磁盘上即可。