模型广场中的模型部署及调用

本文主要介绍如何在模型广场一键快速完成大语言模型的部署,并完成推理服务的接口调用。本文以 DeepSeek-R1-Distill-Qwen-7B 为例进行介绍。

前提条件

-

已经获取控制台账户和密码。

-

已完成实名认证且账户余额大于 0 元。

部署模型

-

登录控制台,默认进入 AI 计算平台。

-

在模型广场页面,选择

DeepSeek-R1-Distill-Qwen-7B模型完成部署,具体操作可参考前文内容。说明 大语言模型目前统一使用 vllm 框架运行推理,同时支持流式和非流式接口。

-

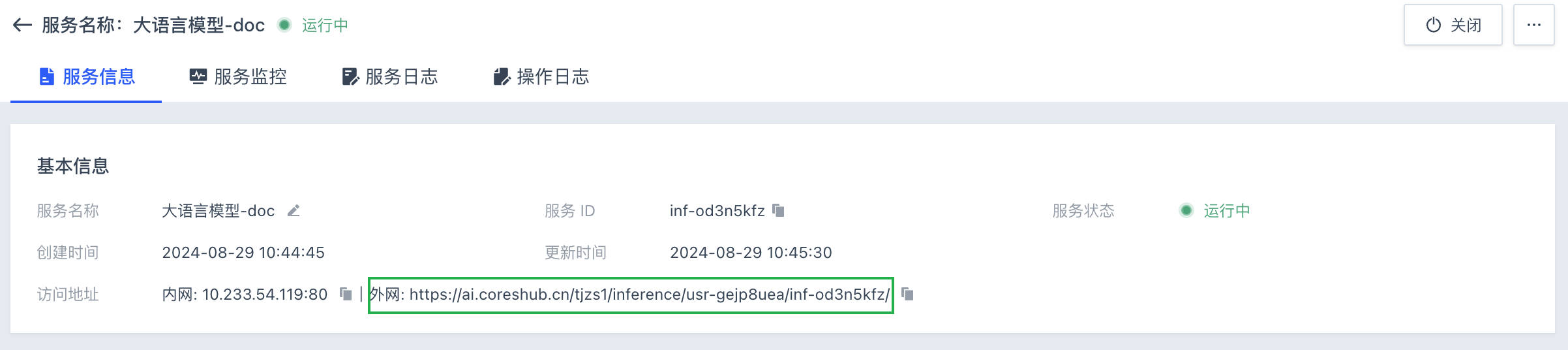

进入推理服务详情页面,在服务信息页签内,获取外网访问地址和 API 密钥。用户点击相应信息右侧的复制按钮

即可。

即可。注意 后续所有 API 调用方式均需使用外网访问地址和 API 密钥。

方式一:手动调用

直接使用 Curl 调用

-

模型部署完成后,用户可打开本地电脑终端。

-

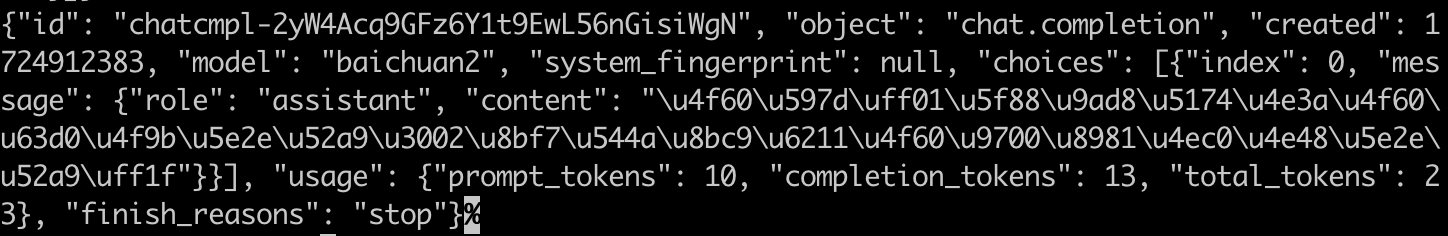

执行如下命令,直接发送 HTTP POST 请求。

curl -X POST \ -H "Content-Type:application/json" \ -H "Authorization:Bearer sk-dUcrQpbouf7OWmzkOTG5LpA1vudBWX4m4FKX5cqP1yTY3yQC" \ -d \ '{"model": "DeepSeek-R1-Distill-Qwen-7B", "do_sample": false, "stream": false, "messages": [{"role": "system", "content": "You are a helpful assistent."}, {"role": "user", "content": "你好"}]}' \ 'http://ai.coreshub.cn/xb2a/inference/usr-5hy8cbjf/inf-gmqpqccv/v1/chat/completions'回显示例:

-

Authorization对应的值sk-xxxxxxxx是模型部署完成后,在服务信息中复制得到的 API 密钥,需根据实际情况进行修改。 -

-d用于指定 POST 请求的正文内容,用户可自行修改。 -

http://ai.coreshub.cn/xb2a/inference/usr-5hy8cbjf/inf-gmqpqccv/v1/chat/completions: 为模型部署完成后,推理服务信息中的外网访问地址/v1/chat/completions。其中,http://ai.coreshub.cn/xb2a/inference/usr-5hy8cbjf/inf-gmqpqccv为推理服务的外网访问地址,在服务信息中复制得到,需根据实际情况进行修改。

-

使用 API 测试工具

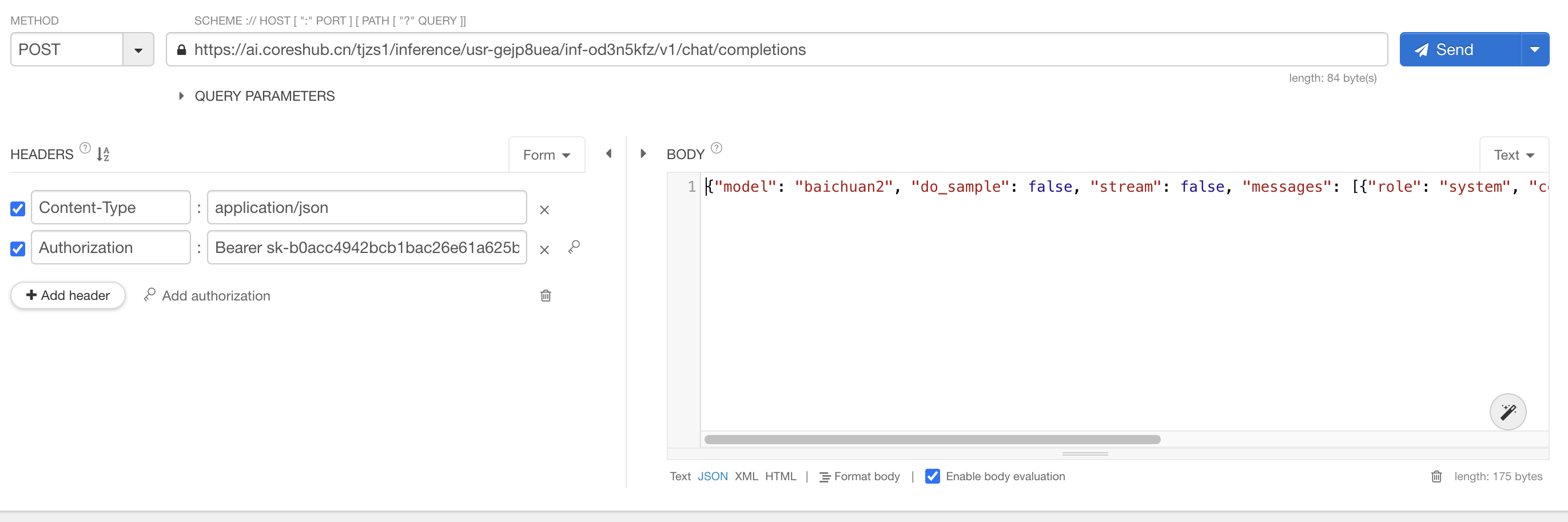

本示例直接使用 Talend API Tester 浏览器扩展工具为例,其他工具如 Postman 使用方法类似,用户可自行选择。

-

模型部署完成后,打开浏览器,开启 Talend API Tester 插件。

-

配置 AIP 调用的各项参数。

-

METHOD:选择

POST方法发送请求,并填写 URL,即外网访问地址/v1/chat/completions。其中,推理服务的外网访问地址,在服务信息中复制得到,需根据实际情况进行修改,故本示例为:http://ai.coreshub.cn/xb2a/inference/usr-5hy8cbjf/inf-gmqpqccv/v1/chat/completions -

HEADERS:请求头需选择

Content-Type为application/json。新增Authorization并填写模型部署完成后,在服务信息中复制得到的,形如sk-xxxxxxx的 API 密钥,需根据实际情况进行修改。 -

BODY:即请求的正文内容,用户可自行修改。

-

-

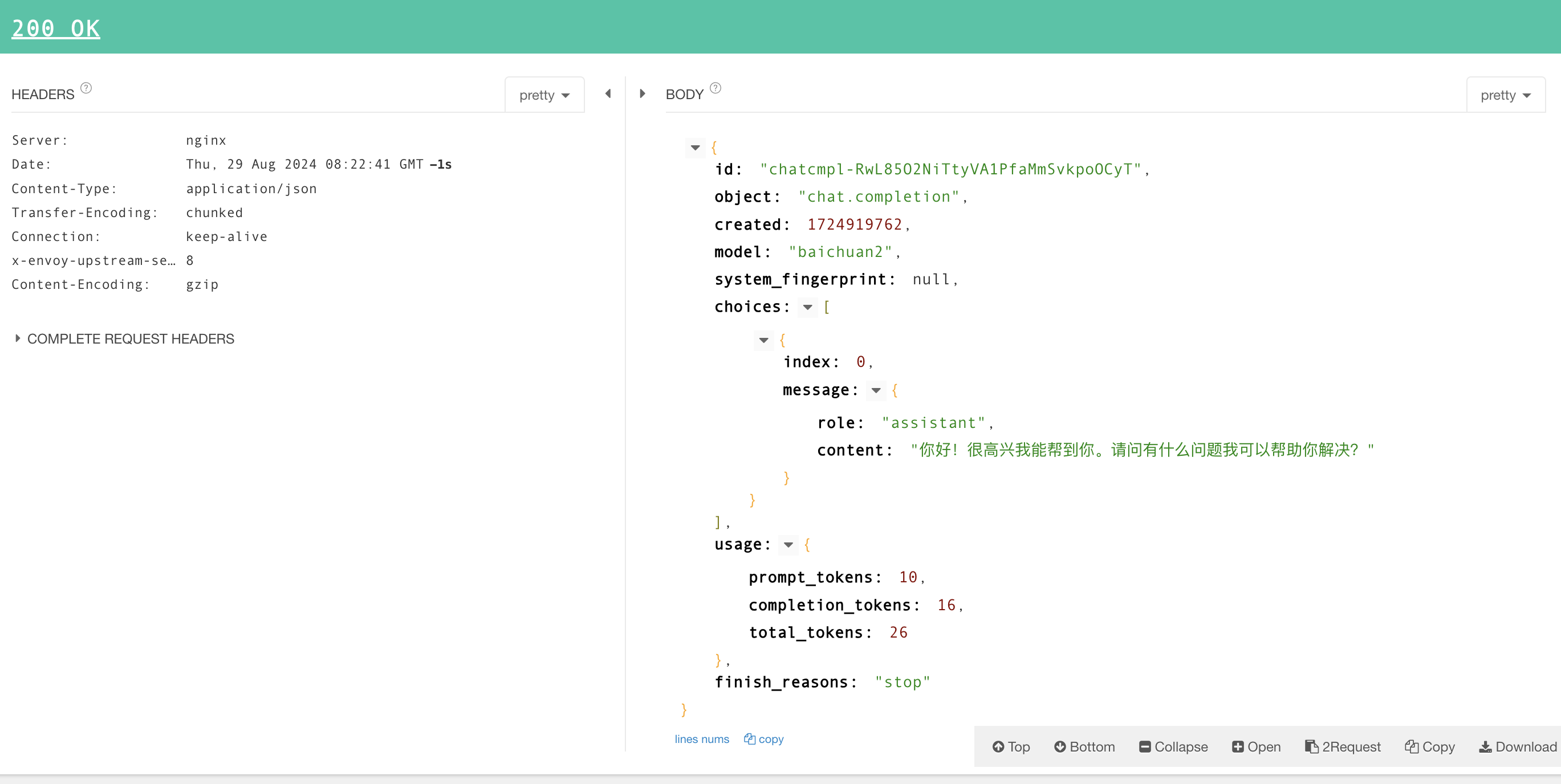

点击 Send,API 调用响应如下。

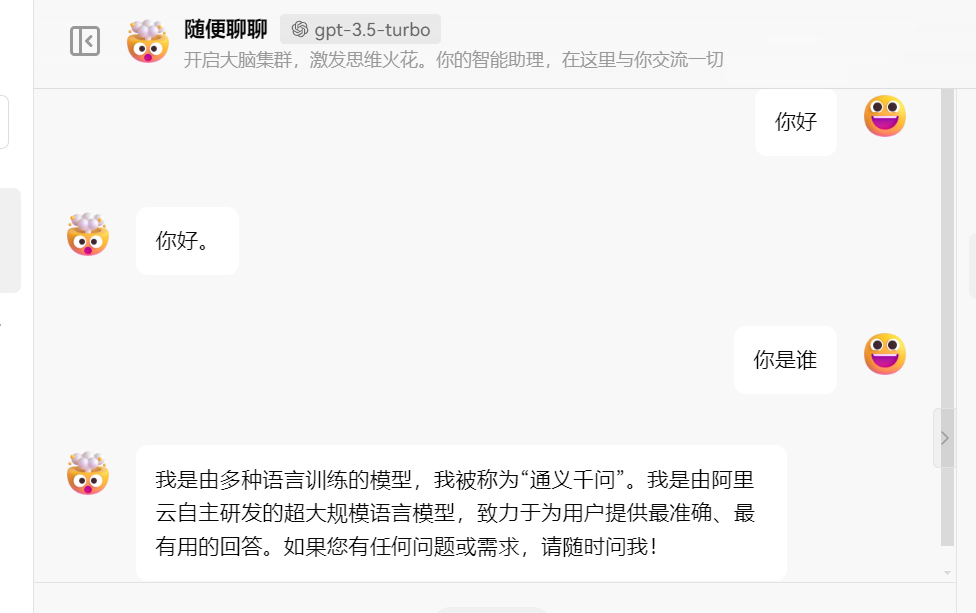

方式二:使用第三方客户端调用

-

完成模型部署。

-

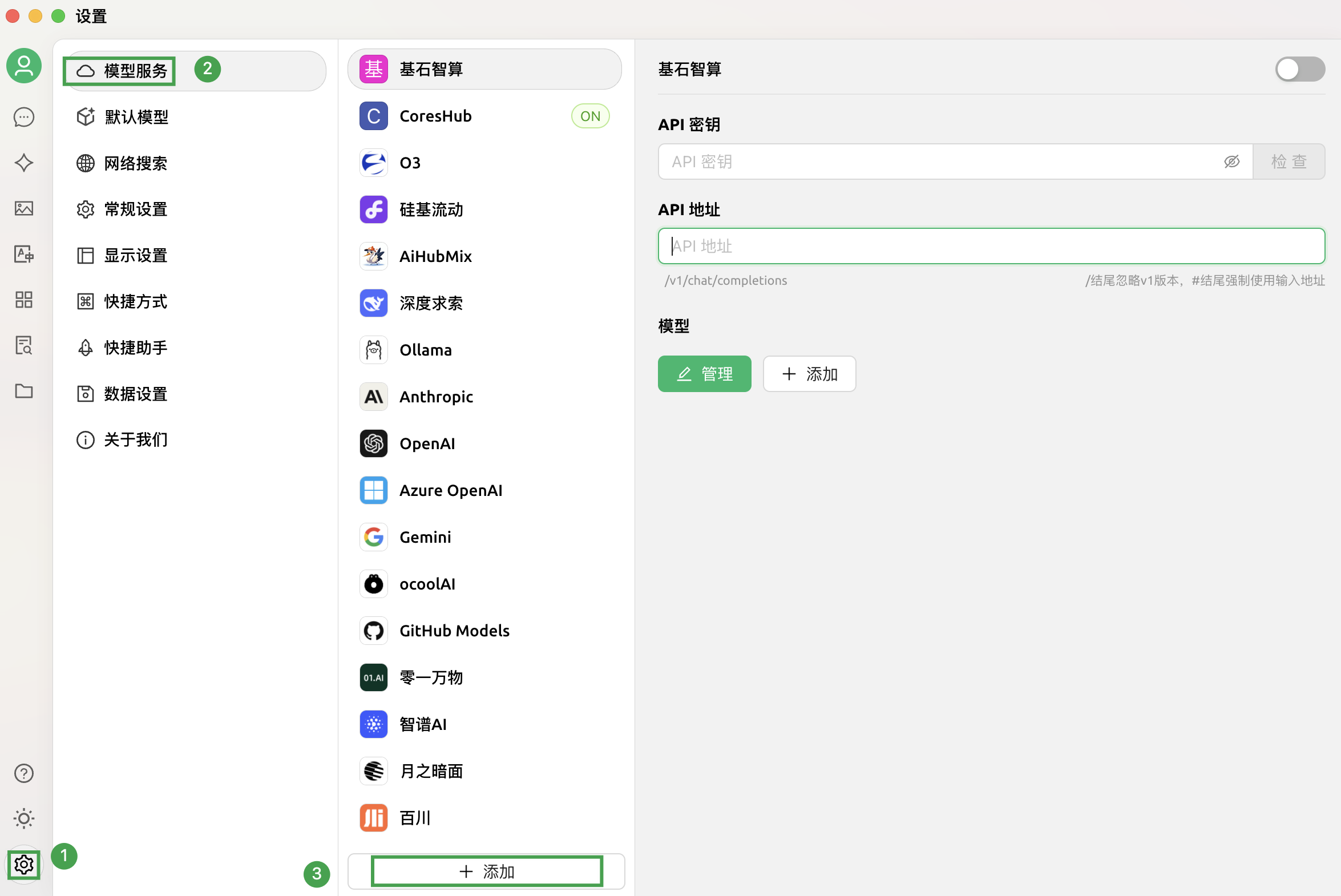

开启第三方工具,点击界面左下角的设置图标,选择模型服务 > 添加。

说明 本实践以 CherryStudio 为例,其他第三方工具用户可自行参考相应的官方说明进行配置。

-

在弹出添加提供商窗口中,配置各项参数,点击确定。

-

提供商名称:用户自定义即可,本实践命名为基石智算。 -

提供商类型:智算平台的模型服务,兼容 OpenAI 接口规范,此处选择OpenAI即可。

-

-

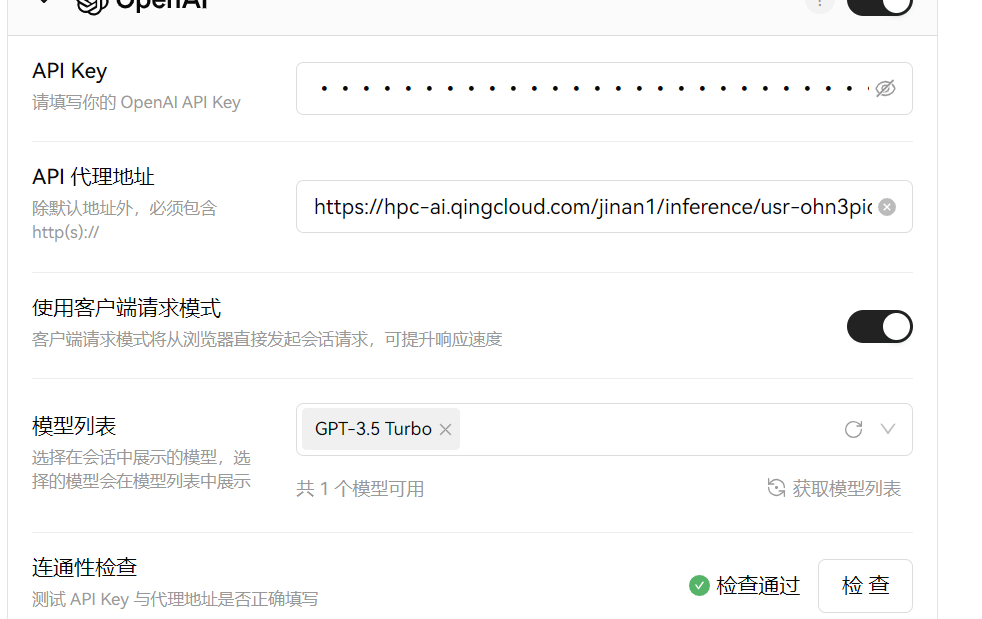

新添加的提供商已显示在列,配置相应的 API 密钥和 API 路径,并点击管理。

-

API 密钥:即模型部署完成后,服务信息页面获取到的API 密钥,需根据实际情况进行修改。 -

API 路径:即模型部署完成后,服务信息页面获取到的外网访问地址,需根据实际情况进行修改。注意,CherryStudio 平台填写路径时需忽略 v1 版本,故仅填写模型服务的外网访问地址即可,需省略末尾的/。注意 -

其他三方工具(如 Chatbox)填写 API 域名和路径时,可能无需忽略 v1 版本,则此时该参数应该为

外网访问地址/v1/chat/completions,具体形如:http://ai.coreshub.cn/xb2a/inference/usr-5hy8cbjf/inf-gmqpqccv/v1/chat/completions。 -

其他第三方工具(如 Dify)填写 API 域名和路径时,仅需填写至

/v1即可,具体形如http://ai.coreshub.cn/xb2a/inference/usr-5hy8cbjf/inf-gmqpqccv/v1。

-

-

-

在弹出的新窗口中,可查看到可使用的模型,点击

图标,即可将相应模型添加至 CherryStudio 平台。

图标,即可将相应模型添加至 CherryStudio 平台。

注意 若此处未显示可用的模型,在 API 密钥和 API 路径填写正确的前提下,请耐心等待模型服务完全启动后,重新点击上一步的管理按钮。

-

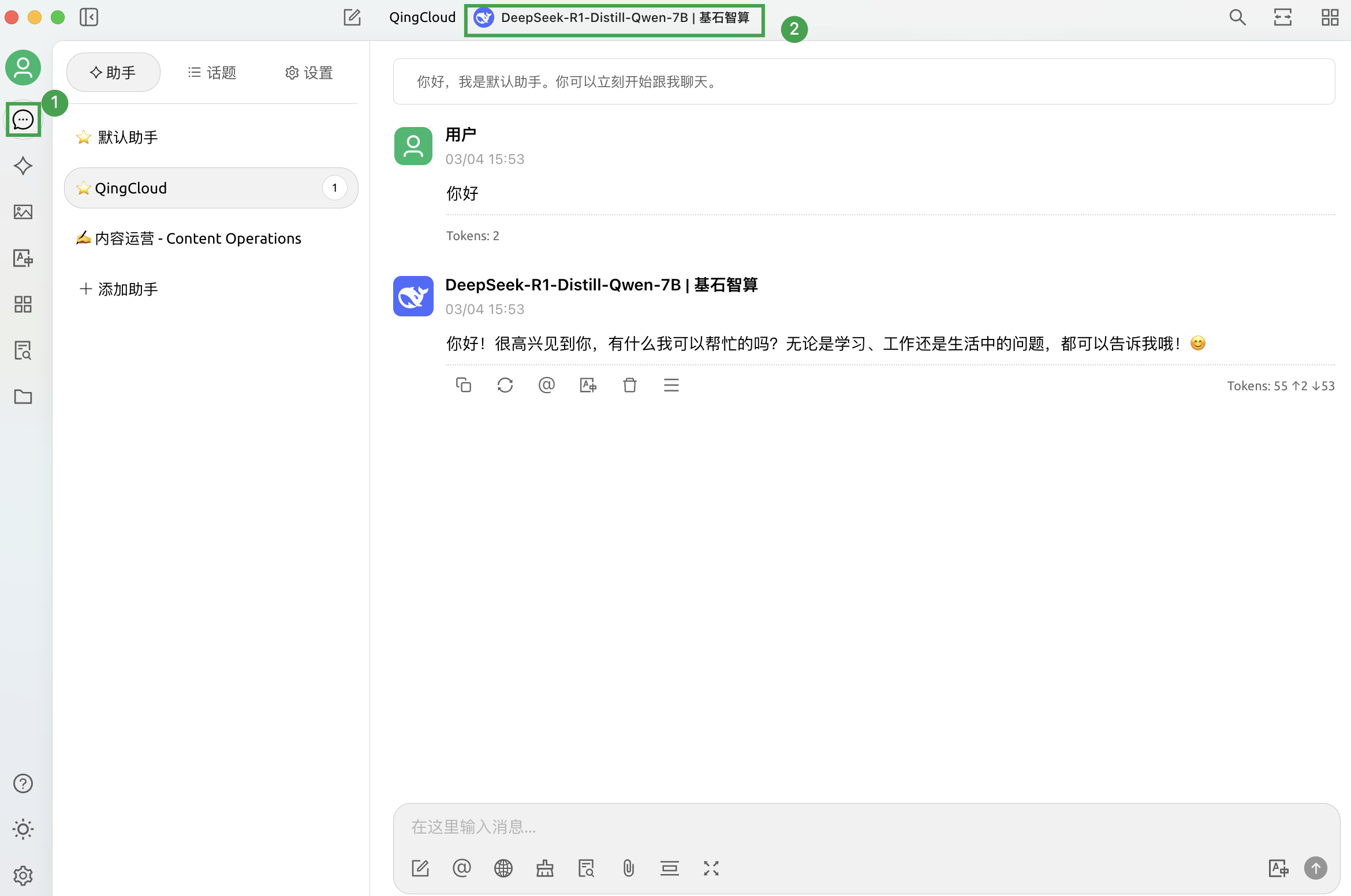

在 CherryStudio 平台,点击左侧导航栏中的聊天助手,在对话框的顶部,切换已添加至平台上的 DeepSeek-R1-Distill-Qwen-7B 模型,即可进行对话。

方式三:临时调用

推理服务的外网访问链接生成后,可直接通过修改外网链接的方式,使用浏览器使用大语言模型。

-

完成模型部署,获取外网访问链接。

-

将外网访问链接中的 inference 字段修改为 inference-web。

例如,外网连接为:

http://ai.coreshub.cn/xb2a/inference/usr-5hy8cbjf/inf-gmqpqccv/修改为:

http://ai.coreshub.cn/xb2a/inference-web/usr-5hy8cbjf/inf-gmqpqccv/ -

在浏览器中输入修改后的外网链接,即可直接使用。